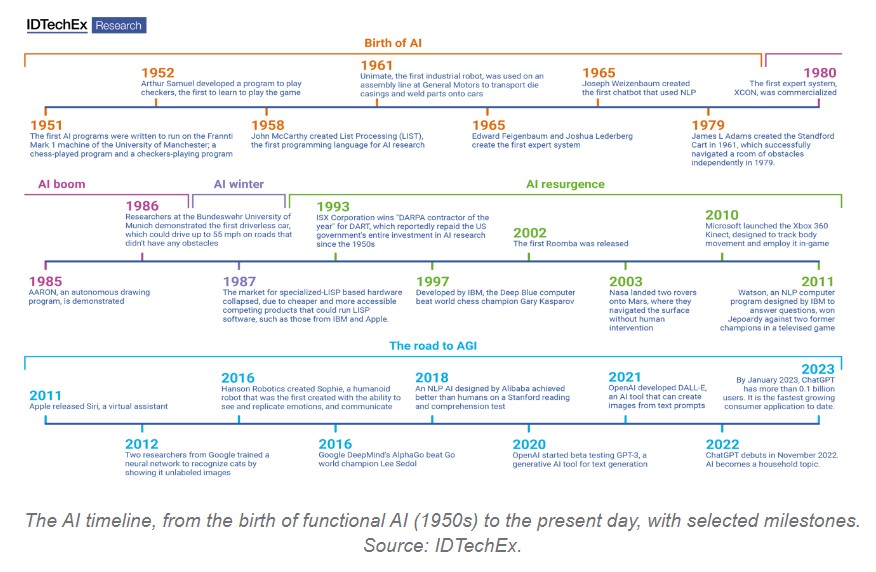

Chiunque abbia accesso alle piattaforme di social media avrà probabilmente già sentito parlare di ChatGpt. Creato da OpenAI e rilasciato nel novembre del 2022, lo strumento di intelligenza artificiale generativa ha avuto 100 milioni di utenti registrati a tre mesi dal rilascio, e il chatbot più avanzato al mondo è stato utilizzato per rispondere a semplici domande, scrivere canzoni e redigere comunicati stampa, il tutto con diversi gradi di successo. Sebbene in ambito creativo ChatGpt non sia (ancora) in grado di competere con la mente umana, le sue capacità sono a dir poco sbalorditive e hanno il potenziale di trasformare interi flussi di lavoro. Tuttavia, oltre alle opportunità offerte dall'IA generativa, ci sono anche dei rischi.

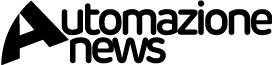

Nel recente rapporto "AI Chips 2023-2033", IDTechEx ha previsto che il mercato globale dei chip AI crescerà fino a superare i 250 miliardi di dollari entro il 2033, con i settori IT & telecoms, Bfsi (Banking, financial services and industrial) e consumer electronics in testa in termini di fatturato generato fino al 2033. Questa crescita è resa possibile dalla crescente complessità e funzionalità dei modelli di apprendimento automatico, che rappresentano opportunità significative sia per le aziende che per i consumatori. Tuttavia, l'uso improprio degli strumenti di IA rappresenta una minaccia per i gruppi sopra citati. È necessario adottare misure per garantire che le opportunità offerte dall'IA avanzata superino di gran lunga le minacce, suggerisce Leo Charlton, Technology Analyst at IDTechEx.

IA e sicurezza: questioni di proprietà e responsabilità

ChatGpt, Dall-E 2 e Siri sono tutti esempi di strumenti di IA generativa, prosegue l'analista. Si tratta di sistemi in grado di generare testo, immagini o altri media in risposta a richieste, in cui i dati prodotti si basano sui set di dati di addestramento utilizzati per creare e perfezionare i modelli utilizzati. Le attuali leggi in materia di proprietà intellettuale (IP) non sono particolarmente adatte a considerare la proprietà legale di beni immateriali come quelli che gli strumenti di IA possono generare. La legge sui brevetti considera generalmente l'inventore come il primo proprietario dell'invenzione. Nel caso dell'IA, chi inventa? L'uomo crea la richiesta (iniziale), ma è lo strumento di IA a creare l'output. Un'IA può anche essere utilizzata per sollecitare altri strumenti di IA, e quindi l'IA può agire sia come sollecitatore che come creatore. Tuttavia, la concessione di uno status di proprietà intellettuale a uno strumento di IA - allo stato attuale - conferisce necessariamente all'IA lo stesso status esteso a una persona giuridica.

È qui che si pone la questione della responsabilità e dell'etica: se l'IA è il proprietario legale di un lavoro, allora l'uomo che ha impiegato, commissionato o utilizzato lo strumento di IA è esente da colpe. Ciò potrebbe essere considerato contrario all'etica, in quanto l'utente umano dovrebbe assumersi una certa responsabilità per le ramificazioni etiche dell'uso di uno strumento di IA (in particolare nel caso di un uso illegale dell'IA, come l'assistenza nella scrittura di uno script per un malware). Un modo possibile per ovviare a questo problema è concedere all'IA lo stesso status giuridico di un bambino, in cui l'utente umano sarebbe analogo al tutore di un bambino, e quindi avrebbe una certa responsabilità, mentre l'IA manterrebbe la proprietà. Sebbene questo garantisca che l'utente umano si assuma la responsabilità delle azioni dello strumento di IA, non affronta adeguatamente il problema dell'IA autonoma, per la quale non è necessario l'intervento dell'uomo. Inoltre, i legislatori potrebbero essere contrari a conferire uno status giuridico alle macchine.

Altri soggetti che dovrebbero essere presi in considerazione sono gli sviluppatori dello strumento di IA, nonché i proprietari dei dati che compongono il set di dati utilizzato per addestrare lo strumento di IA (una componente chiave del ragionamento alla base del divieto italiano di ChatGpt nel marzo 2023). La risposta alla questione della proprietà è una questione che verrà cercata con maggiore urgenza man mano che gli strumenti di IA e i loro risultati cresceranno, come sicuramente accadrà nei prossimi anni.

Partire da linee guida chiare

Laddove l'IA può essere utilizzata per buone intenzioni - come ad esempio per aiutare la sintassi appropriata per la scrittura di script per computer e per individuare transazioni finanziarie fraudolente - può anche essere usata per scopi malvagi, che vanno dall'inganno all'illegalità. Dato che gli strumenti di IA generativa possono essere utilizzati per assistere la scrittura di copioni, per lo strumento non è particolarmente importante il tipo di copione che viene scritto. Per questo motivo, l'IA generativa può essere utilizzata per assistere la scrittura di malware (software maligno). Lo strumento di IA utilizzato, ovviamente, non ha creato intenzionalmente un malware, ma questo potenziale maltrattamento di un sistema nominalmente apatico deve essere affrontato.

L'IA generativa è molto efficace per semplificare alcune funzioni lavorative, come i testi pubblicitari e i materiali di marketing. Tuttavia, rimane il problema della proprietà e della responsabilità. Dal marketing ai consumatori (dove le aziende saranno ancora responsabili per un linguaggio ambiguo o diffamatorio) alle istituzioni accademiche (dove l'uso di uno strumento linguistico da parte di uno studente per scrivere una parte della tesi di laurea mette in discussione la legittimità del titolo conferito), è necessario fornire chiare linee guida - normative e legali - per un uso corretto di tali strumenti.

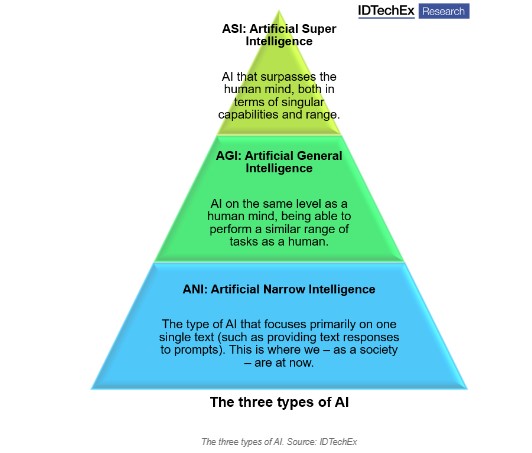

In definitiva, conclude Charlton, siamo ancora lontani dal tipo di minacce esistenziali poste dall'IA che sono al centro di opere di fantascienza fondamentali, come "2001: Odissea nello spazio" e "Terminator". Tuttavia, anche se la tecnologia dell'IA progredisce verso l'Intelligenza Artificiale Generale, sono necessarie pratiche e codici di condotta chiari per garantire che i rischi siano adeguatamente mitigati, in modo che l'IA trasformi le industrie in meglio. Le opportunità nei tre settori verticali sopra citati e in altri sono discusse nel nuovo rapporto IDTechEx "AI Chips 2023-2033".